在数据驱动的时代,数据分析工具的选择对工作效率和决策质量至关重要。面对市场上琳琅满目的工具,如何做出明智的选择?关键在于从数据处理的核心需求出发,综合考虑多个维度。以下是选择合适数据分析工具的实用指南。

一、明确数据分析的目标与规模

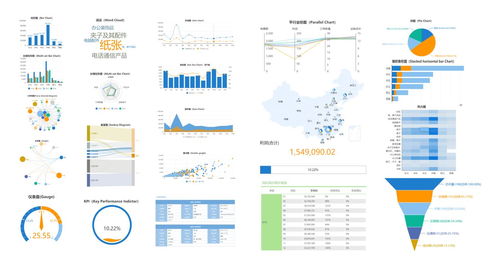

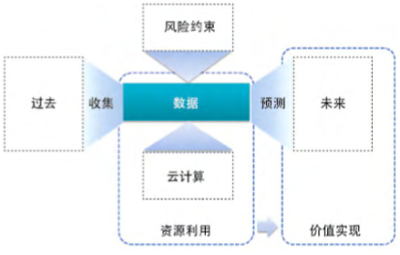

清晰定义分析目标。是进行探索性数据分析(EDA)、制作可视化报表、构建预测模型,还是执行复杂的数据挖掘?不同目标对应不同的工具:

- 探索性分析:适合使用Python(Pandas、Jupyter)或R,它们灵活且拥有丰富的统计库。

- 商业智能(BI)报表:Tableau、Power BI或FineBI等可视化工具更高效。

- 大规模数据处理:需考虑Hadoop、Spark等分布式框架。

评估数据规模。小数据集(如Excel表格)可能用Excel或简单脚本即可;而TB级大数据则需要专业的大数据平台。

二、评估数据处理的技术需求

数据处理涉及清洗、转换、整合等环节,工具需满足技术要求:

- 数据清洗能力:检查工具是否支持缺失值处理、去重、格式转换等功能。Python的Pandas和OpenRefine都是强大选择。

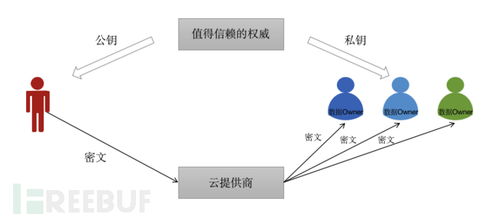

- 数据源兼容性:工具应能连接多样数据源,如数据库(MySQL、PostgreSQL)、云服务(AWS、Google Cloud)或API。KNIME和Alteryx在此方面表现突出。

- 处理速度与性能:对于实时数据处理,需考虑流处理工具如Apache Kafka或Flink。

三、考虑团队技能与协作因素

工具的选择必须与团队能力匹配:

- 学习曲线:非技术团队可能更适合拖拽式工具(如Tableau Prep或Trifacta),而开发团队则可驾驭编程型工具。

- 协作功能:现代数据分析常需团队合作。寻找支持版本控制(如Git集成)、共享仪表板或云端协作的工具,例如Databricks或Google Data Studio。

四、权衡成本与可扩展性

预算是现实约束:

- 开源工具:如Python、R、Apache Superset,成本低但需自主维护。

- 商业软件:如SAS、IBM SPSS,提供专业支持但费用较高。

考虑长期可扩展性。选择能够随着业务增长而扩展的工具,避免频繁迁移数据带来的麻烦。

五、实践建议与常见陷阱

- 先行试用:大多数工具提供免费试用版,亲身体验后再决定。

- 避免“一刀切”:不同场景可能需组合使用多种工具,例如用Python处理数据,再用Tableau可视化。

- 警惕过度复杂化:不要盲目追求功能最全的工具,简单高效的方案往往更可持续。

###

选择数据分析工具没有唯一标准答案,但遵循“需求驱动”原则能大幅降低决策风险。回归数据处理的本源——你究竟想从数据中获得什么?答案将指引你找到最适合的利器。记住,最好的工具是那个能让数据流畅转化为洞察的伙伴。